Google Cambia Rotta: Una Nuova Era nell’Intelligenza Artificiale

Le Nuove Linee Guida di Google

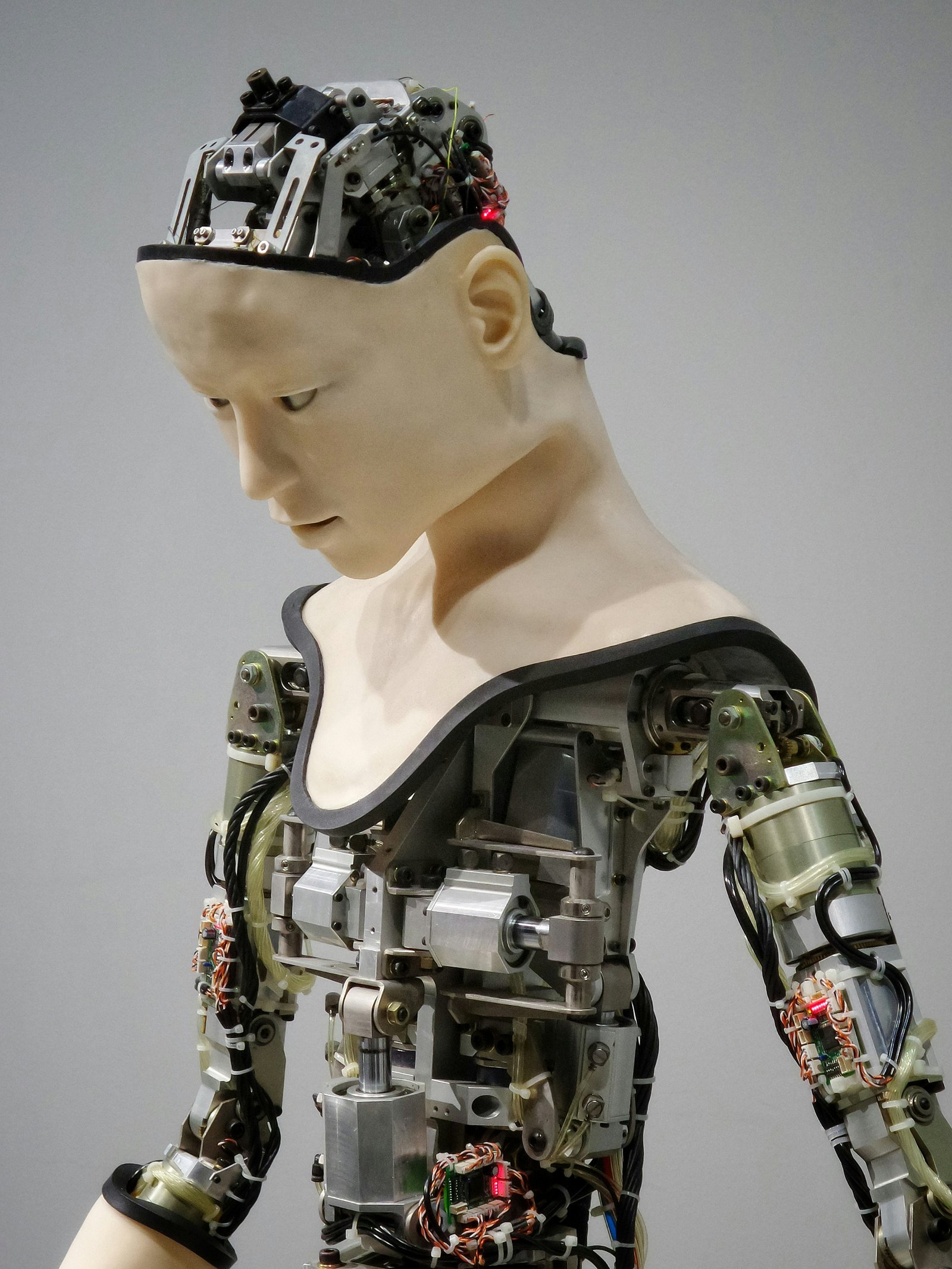

Recentemente, Google ha fatto notizia per la sua decisione di rivedere le linee guida relative allo sviluppo dell’intelligenza artificiale. Per molti anni, l’azienda aveva mantenuto una promessa di non sviluppare armi, ma ora, in un contesto geopolitico complesso, sembra che i tempi siano cambiati. La nuova strategia di Google apre le porte a possibilità precedentemente impensabili.

La Geopolitica e le Implicazioni per l’IA

Con l’intensificarsi delle tensioni globali e le sfide emergenti, Google ha riconosciuto che le sue politiche dovevano adattarsi. La decisione di eliminare il divieto di sviluppare applicazioni per armi e sorveglianza si inserisce in una narrativa più ampia, in cui le aziende tecnologiche svolgono un ruolo cruciale nella sicurezza nazionale e nella difesa. Ma quali sono le implicazioni di questa scelta?

Etica e Responsabilità delle Aziende Tech

Questa svolta pone domande importanti sulla responsabilità delle aziende tecnologiche. Mentre Google avanza verso un futuro in cui l’IA può essere utilizzata anche in ambiti militari, la questione etica diventa centrale. Come garantire che lo sviluppo di queste tecnologie non oltrepassi i confini umani? La comunità globale sta già discutendo delle linee guida necessarie per un uso responsabile dell’intelligenza artificiale nelle applicazioni più delicate.

In conclusione, la decisione di Google di cambiare rotta segna un punto di svolta significativo. L’industria deve riflettere attentamente su chiari principi etici per navigare in questo nuovo panorama.